自动驾驶技术一直是近年的研究热点,特斯拉已研制出能在较少车辆的道路上实现自动驾驶的系统,据称两年左右就能上市。而在过去的9个月里,Nvidia工程团队用一个摄像头、一台Drive-PX嵌入式电脑、72小时的训练数据开发了一台自动驾驶汽车。在Cornell Research Library拥有的arXiv.org(全球最大的预印本系统)上,Nvidia以学术预印本的形式发表了DAVE2的研究结果,标题名为《自动驾驶汽车的端到端学习》。

Nvidia的项目名叫DAVE2,为什么这样命名?因为美国国防部先进研究项目局(Defense Advanced Research Projects Agency)有一个项目名叫DARPA Autonomous Vehicle(DAVE,既DARPA无人驾驶汽车)。虽然神经网络、自动驾驶汽车看起来是一门新发明的技术,实际上谷歌的Geoffrey Hinton、Facebook的Yann Lecune、蒙特利尔大学的Yoshua Bengio在过去20年里一直在携手研究它,这些技术是AI的一个分支。DARPA DAVE项目申请研究神经网络自动驾驶汽车,它的前身是ALVINN项目,这个项目是Carnegie Mellon 1989年提出的。有一点已经改变:由于GPU的发展,研究变得经济可行了。

神经网络、图像识别应用(比如无人驾驶汽车)最近出现了大爆发,主要原因有两个。第一个,手机上渲染图像的GPU已经很强大,很便宜,将GPU大规模装载到板件等级的超级电脑上可以很好地解决庞大的并行神经网络问题,而且它的价格也足够便宜,每一名AI研究人员和软件开发者都买得起。第二,大型、标签式图片数据集已经存在,我们可以用它来训练大型并行神经网络,这些神经网络用GPU来执行,可以看见、感知摄像头捕捉的物体。

绘制人类驾驶模式

Nvidia团队训练了一个卷积神经网络,它可以绘制单个前置摄像头捕捉的原始像素,摄像头跟驾驶命令直接联系。Nvidia技术的突破之处在于:无人驾驶汽车可以自动自学,通过观看人类的驾驶方式自学。

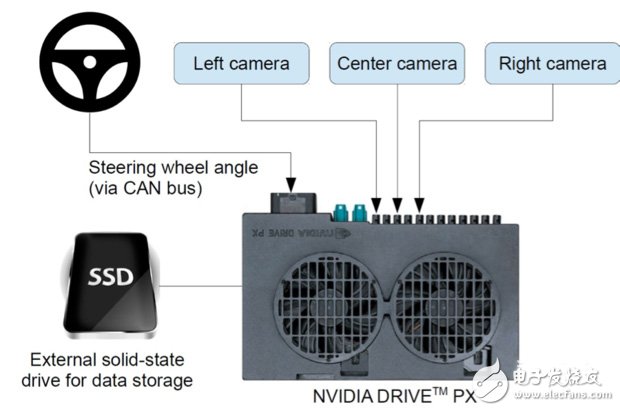

虽然操作系统使用的是一个摄像头和一台Drive-PX嵌入式电脑,但是训练系统使用的却是三个摄像头、两台电脑,它们可以抓取3D视频图像、转向角度(来自人类驾驶的汽车),这些信息可以训练系统学会“看见”和“驾驶”能力。

Nvidia会监视转向角度的变化,将它作为训练信号,然后将人类驾驶模式映射到摄像头记录的位图图像中去。系统会利用卷积神经网络为驾驶处理步骤介定内部表征,比如侦测有用的道路特征——线路、汽车和道路轮廓。

自动驾驶汽车会感知路况、其它汽车及障碍物,开源机器学习系统Torch 7会对处理过程进行深入学习,然后用来操纵测试汽车。实际训练以每秒10帧的速度进行,因为即使速度达到30帧区别也不会太大,学习的价值并不会提高。测试车包括一辆2016款林肯MKZ和一辆2013款福特福克斯。

机器学习处理的核心就是用Torch 7构建的卷积神经网络模拟操纵情况。人类驾驶的汽车会拍摄一些10fps图像,卷积神经网络会下达操纵命令,对10fps图像进行模拟响应,研究人员需要将模拟响应和人类转向角度进行对比。一个是人类转向角度,一个是卷积神经网络模拟的操纵命令,它可以教会系统“看”和“操纵”的能力,研究者需要对两者进行对比,分析其中的差异。汽车会在测试路线上行驶3小时,总里程相当于100英里,行程会被记录为视频,模拟时使用的测试数据来自于视频。

公路测试

当卷积神经网络模拟驾驶表现良好时,就可以在公路上对测试车辆进行更进一步的机器学习和测试了。公路测试可以改进系统,在整个过程中需要由人类司机监督无人驾驶汽车,当系统出错时及时介入。每修正一次,结果就会输入到机器学习系统,从而改进操纵过程的精准度。在新泽西Turnpike的行驶过程中,前10英里汽车完全自动行驶。在早期测试中,98%的操作是无人驾驶的。

Nvidia证明卷积神经网络可以学会以下任务:道路侦测,非手动道路追随,对道路及道路标识、语义抽象、路线规划、控制进行明确的分解和分类。让汽车在不同天气、灯光条件、高速公路或者旁路上行驶,获得内部处理过程,形成不到100小时的训练数据,然后用Torch 7渲染这些数据,系统就可以学会上述操作。

从报告看,Nvidia暗示系统还没有准备好投入生产,它在报告中写道:“如果要提高网络的稳定性、找到好办法核实这种稳定性,提高网络内部处理过程的可视化水平,我们还有更多的工作要做。”