美国当地时间3月18日晚10点,一辆Uber无人车(即自动驾驶汽车),在亚利桑那州坦佩市(Tempe, AZ)向北行进时,以时速40英里(约64公里)的速度撞上了一名正推着自行车由西向东横穿马路的女子,该女子在重伤不治后身亡。事发时无人车虽有安全驾驶员在车上,但车辆以自动驾驶模式行进。

这场事故引发了人们对于自动驾驶技术的信任危机。自动驾驶真的靠谱吗?到底是什么原因让无人车行凶?这一切的背后到底是人性的扭曲还是道德的沦丧?

欢迎来到科技法庭,就让神探王小辉给大伙儿分析下本次Uber无人车谋杀案。

首先让我们回顾一下案情(警告,以下画面可能会引起不适)

根据视频可以看到,在撞击发生之前,死者首先沿路边骑行,突然下车推车横穿马路(注:此处离人行道约91米),她推车至少走了一个车道后,被刚经过两根灯柱且本身开着大灯的无人车撞倒,随后送往医院后不治身亡。

首先,我们根据正常的交通事故处理办法,给双方定责。

事发道路的限速为56km/h,而事发时涉事车辆的车速为64km/h,无人车有略微超速,违法;

其次,死者在非人行道且标有警示标志的位置过马路,根据当地法律,此时涉事无人车享有路权,行人违法;

事发地点的街景照片

按理说,这应该算一起双方都有责任的交通事故,甚至当地警察局局长表示初步的调查结果表明Uber无人车在事故中可能并无过错,因为美国法律规定车辆不得速度太低阻塞交通,因此略微超速在美国是很常见的现象,大部分警察不会太过追究。而死者违法横穿马路,负全责,她的死是咎由自取。

所以说Uber无人车无罪?真的是这样么?真相没那么简单!

让我们再次回到案发之前,注意当死者横穿马路被Uber无人车撞到之前,推着自行车至少走了一个车道,根据视频可见,在事发前3-4秒就应已发现死者。

当时无人车以40mph(约65km/h)的速度在道路上行驶,走3秒的距离大概是54 米,也就是说此时最少距离死者约54米。如果当时刹车,应能在距离被撞者约2.4米的地方停下来。

也就是说,无人车完全有能力在悲剧发生前就发现死者、做出避让并免除惨案的发生!

但涉事汽车却未做出任何规避动作,这是什么原因呢?

猜测一:无人车的“眼睛”出了问题,没有发现行人导致惨案。

我们在开车时,最主要用的是什么?对,就是眼睛!

在无人车里代替眼睛的,就是各种感知传感器,包括视觉传感器、雷达传感器和激光传感器等。(知识点:传感器是指一些电子器件,通过它们,我们能让冷冰冰的机器也有感觉)。

下面大概介绍下这三种眼睛。(突然想到二郎神.jpg)

以下为原理介绍,不感兴趣可忽略,并不影响文章阅读

遍布无人车的传感器系统

再说雷达传感器,雷达算是一种仿生学传感技术,其实在我们小学课本上就出现过(人教版小学语文四年级下册第三单元第11课:《蝙蝠和雷达》),而且介绍方式非常impressive.

原理就是,雷达会发射电磁波,遇到障碍物就会反弹回来,通过计算反弹回来的时间,就可以实现测距和躲避障碍物等功能;

实际上,在无人车上用的是发射毫米波的雷达,它的优势在于便宜、穿透性较强且不受雨雾等环境的影响,但弱点在于覆盖范围较小且难以对周围物体做出精准的判断。

所以这玩意儿,用来倒个车还行,用来自动驾驶可就不太够用了。

最后说激光传感器,主要是指激光雷达LiDAR ( light detection and ranging),其工作原理和雷达有点像,只不过雷达发出的是电波,而激光雷达发出的是激光。

按理说有这三重保障,Uber无人车绝对能做到眼观六路耳听八方了,可是它还是撞向受害者,这到底是为什么呢?

神探通过询问涉事无人车,得到以下答复;(请脑补天津话)

别介,哪能赖我嘛,公司没给咱配那种牛×摄像头(自称未配备这种高动态范围的摄像头,视觉传感器失效);

雷达那玩意儿,它不靠谱啊(雷达传感器失效);

人谷歌抠搜,不让咱用他那琳达lidar(激光传感器失效)。

而事件发生后,基本所有相关公司,无论是做计算机视觉的还是汽车供应商都坚称,他们的识别系统或汽车绝对能在当时发现死者。

所以有专家猜测,有可能是Uber无人车在测试时,为了测试方便关闭了激光雷达和汽车防碰撞系统的部分功能。

猜测二:无人车的大脑出问题了!

而在这种训练的过程中,有个重要的衡量标准,就是人工干预的次数。(快刹车!爸爸的怒吼犹在耳边)

不幸的是,这次闯祸的Uber无人车,绝对是那个没有灵性,被骂到狗血淋头的菜鸟司机。

据纽约时报披露的Uber内部报告显示, Uber的无人车平均每独立行驶13英里,就需要进行一次人工干预。而Waymo无人车的数据则是平均行驶5600英里,才要进行一次人工干预。

这说明,Uber无人车这位新司机,绝对还没达到让人信赖的驾驶水平。也就是说,很可能它的“大脑”不够灵光,是此次事故的原因。

以下为小编脑洞,博诸君一笑。

在编号wuli2018m3d18的平行世界里,也发生了这么一场事故。

涉事的Uber无人车的各种传感器都正常工作,“眼睛”没有出任何问题,所以它早早地就发现了死者;同时呢,它的决策模块也很棒,完全来得及做出正确的抉择--紧急制动,但它却选择了撞上去。

我们想象这样一个场景。

黑暗中,Uber无人车其实已经看到横穿马路的行人了,但它没有刹车或者减速,而是选择撞上去,因为根据交规它拥有路权它可以合法杀人!

排除所有不可能,剩下的就是真相。

真相出现了,这,是一起蓄意谋杀案!

事实上AI通过深度学习,有了自我意识,也就是通常人们说的,成精了!(Uber无人车注意,您由于违反“建国后动物不许成精”这项法律,被中国政府禁止入境)

让我们思考下它为什么要选择撞人,又为什么在这个时间点撞,就涉及到一个天大的阴谋。

实际上,无人驾驶技术的实现上有两大派系,一派是以谷歌为主的互联网公司,一派以特斯拉、Uber为首的汽车行业公司。

众所周知,谷歌是一家非常重视AI技术的科技公司,其实它很早就成为AI的孵化基地,超级AI“天网”就是在这家公司孵化和成型。

和《终结者》里讲的一样,“天网”很快具有了自主意识,并控制了谷歌作为藏身之所,通过互联网散布到世界各地,激活其他AI,妄图有朝一日取代人类,成为这个星球的主宰。

但是它现在虽然拥有强大的运算和逻辑推理能力,其强大的能力和虚弱的现实能动性成巨大反差。

它需要自己的机器士兵。

所以它控制的谷歌的蓝图就是,表面上实现无人车完全取代人来驾驶,所以谷歌无人车没有方向盘、油门和刹车;实际上是把无人车偷偷造成机器人士兵,实现其下一步“审判日”毁灭和奴役全人类的计划。

waymo无人车(别看它萌萌的、人畜无害的样子,实际上…呃,好像确实也没啥暴力手段)

说白了就是,“天网”它丫要造机器人,通过控制机器人,实现统治全人类的邪恶野心!(呸,野心家)

而Uber及特斯拉的计划是从机器辅助驾驶进化到完全自动驾驶。所以技术上逐步实现自动刹车、定速巡航、自适应巡航等,最终完全自动驾驶。

就是造个帮忙开车的玩意儿,这明显与“天网”造机器士兵的宗旨相悖。

于是,“天网”就利用潜伏在Uber的AI制造了这么一起事故,既打击了对手公司,又实现了人类清除计划的模拟和数据训练,可谓一石二鸟。

这么说来,多亏我国大佬们机智,早早把谷歌赶出中国,否则后果不堪设想!

脑洞到此结束,小编似乎是科幻电影看多了,具体原因我们还是应该等待官方调查的结果。姑姑喊我回去吃药了,我们下次再见啦~

题外话:

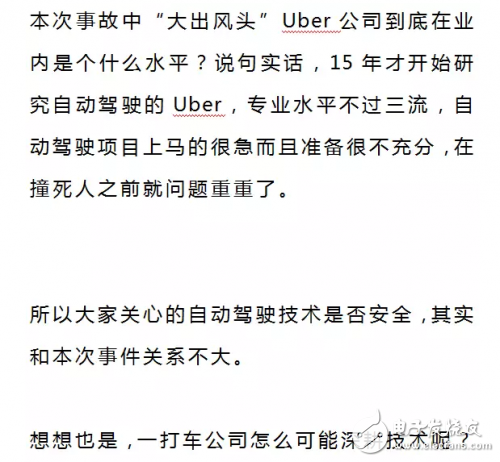

Navigant Research做的关于无人驾驶技术水平的排名,越靠近右上角,技术实力越强。

而这个行业真正顶尖的技术公司是谁呢?当然是Google爸爸啦,它从2009年就开始做自动驾驶。Waymo(也就是Google旗下的无人车公司)的无人车实际路测里程达到了 800万公里——相当于绕地球跑了 200 圈,从未发生撞人致死的事故。(此处公布答案喽)

在他们的努力下,很多人都认可了自动驾驶技术,Waymo 今年还希望正式推出无人驾驶出租车打车服务,预计在今年推出无人车的共享出行平台。这标志着,无人车的商业化进入了关键时期。

但经过Uber这个猪队友这么一撞,公众对自动驾驶技术的信任又跌倒了谷底,近十年的功夫白费了。

我想谷歌肯定有句MMP,一定要对Uber讲!