生成对抗网络(GAN)在机器学习领域展示了创造逼真的图像和视频的巨大能力和潜力。除了其生成能力外,对抗学习的概念是一个框架,如果进一步探索,它可能会导致机器学习的巨大突破。

使用易于理解的解释和图表,本文将本能地解释GAN的工作原理,培训过程中遇到的挑战以及对抗性学习的力量。

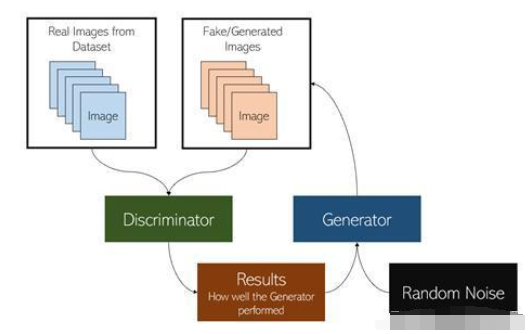

GAN是由两个模型组成的系统:生成器和鉴别器。

鉴别器只是一个分类器,它确定给定图像是来自数据集的真实图像还是来自生成器的人工生成图像。该二进制分类器将采用卷积神经网络的形式。

生成器的任务是获取随机输入值(噪声)并使用反卷积神经网络从中创建图像。将这个概念想像成为随机数生成器设置种子-相同的输入噪声将产生相同的输出。生成器使用随机噪声作为种子来生成图像。

两模型系统的目的是使生成器欺骗鉴别器,而且使鉴别器以其可能的最高准确度对生成器的图像进行分类。两个有价值的对手(生成对抗网络)之间的这场持续战役意味着,两个模型通过击败对方而变得更好。生成器使用鉴别器获取有关其图像的说服力的反馈,并且鉴别器从生成器获取更多数据以进行训练。

反卷积神经网络(DNN)是GAN的核心。它是负责生成图像的算法。顾名思义,卷积神经网络可以被认为是“向后运行CNN”,但其机制要复杂得多。DNN也称为deconv或转置卷积神经网络,其使用的层类似于CNN中的层,但向后的层是向上采样(而不是向下采样),从而使图像更大。

这比CNN困难。通过压缩或概括其信息来缩小图像比在不使图像模糊且具有相同的细节量的情况下放大图像要容易得多。通过转置卷积(反卷积)可以解决此问题。

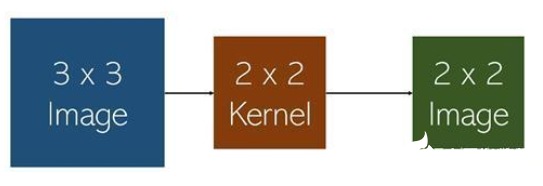

从这个意义上讲,如果DNN是GAN的心脏,那么转置的卷积就是动脉。首先,了解反卷积需要了解卷积。例如,考虑以下卷积:

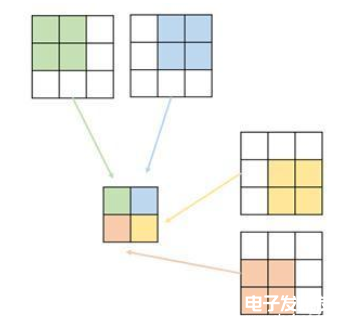

以下卷积按如下步骤执行,假定步幅为1。卷积将图像概括为较低维之一。

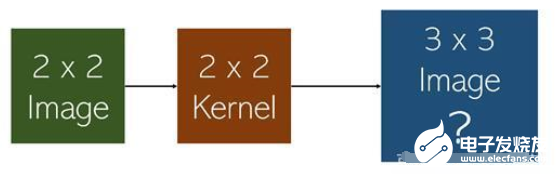

反卷积层的目标与卷积层的目标相反:采取缩小的图像和可训练的核,并预测“原始图像”。在这种情况下,随机噪声将通过一系列反卷积进行转换,以产生更清晰的图像。

这些转置的卷积是根据鉴别结果进行训练的。如果鉴别器性能较差,则需要生成器的当前权重并适当地欺骗鉴别器。但是,如果鉴别器性能良好,则需要大幅改变发电机的当前权重,以降低鉴别器的性能。换句话说,鉴别器是发生器的损失函数。

尽管这种想法具有革命性,但众所周知,GAN很难训练。GAN中的一个常见故障是,鉴别器使生成器过载,以100%的确定性将生成的图像识别为伪造的图像。由于鉴别器充当了去卷积层权重调整的损失函数,因此绝对确定性不会使生成器下降。

训练GAN的另一个常见失败称为模式崩溃,其中生成器发现并利用了鉴别器中的弱点。当GAN生成相似的图像时,无论随机输入的变化如何,都可以在GAN中识别出模式崩溃。这意味着生成器仅生成它已获悉的图像,几乎总是会欺骗鉴别器。这意味着生成器没有改进,因为鉴别器给出的结果很差,这意味着生成器正在产生理想的结果。有时可以通过以某种方式“加强”鉴别器(例如,通过调整其训练速率或重新配置其层)来纠正模式崩溃。

GAN是基于这样的思想,即两个平等匹配的个人之间的竞争既可以改善双方的竞争,又需要对它们进行健康且严格的监管,来让一个人不会剥削另一个人。生成对抗网络和对抗学习作为一个领域仍然很年轻,并显示出巨大的潜力。它们具有塑造数字世界的巨大潜力。