德国汽车零部件供应商大陆集团(Continental)在开发一款增强现实抬头显示系统(AR-HUD),旨在方便地在车辆和驾驶员间提供一种新的对话形式。下面就让我们来看看它是如何工作的。

该显示系统对驾驶员看到的现实交通情况予以展延(增强):光学投影装置精确地将包含了交通状况信息的图形图像投放成外部显示。这样,AR-HUD就可以显著增强车辆的人机界面(HMI)了。

AR-HUD目前已达预生产开发的后期阶段。演示车一方面用来展现其可行性,另一方面,又对后续开发提供了宝贵借鉴。大陆集团计划在2017年完成生产准备。

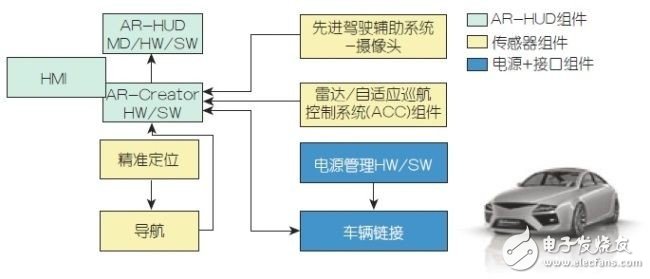

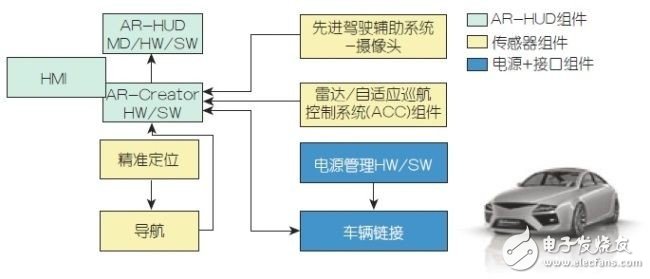

图1:增强现实平视显示系统概述。

AR-HUD:所见即所知

AR-HUD的光学系统使司机能看到驾驶员辅助系统状况的增强显示、以及在其直接视域场这些信息的权重。作为人机界面的新部件,眼下的这款预生产的AR-HUD已经与驾驶员辅助系统环境传感器、以及GPS数据、地图素材和车辆动态数据等紧密整合。

雷达传感器集成在前保险杠,一个CMOS单通道摄像头(mono-camera)集成在后视镜底座。所选的相关先进驾驶辅助系统(ADAS)支持自适应巡航控制系统(ACC)、来自导航系统的道路信息、以及车道偏离警告(LDW)等最初的这些AR-HUD应用。

如果其中一个驾驶员辅助系统检测到一种相关情况,AR-HUD显示的虚拟图形信息,能使驾驶员意识到这一情况。除了直接强化了驾驶安全,这种形式的交互也是自动驾驶的一项关键技术。该增强技术使得驾驶员更容易建立起对新的驾驶功能的信任。

在大陆的AR-HUD中,可产生基于不同投影距离的两个投影面,分别称为“近端”(或“状态”)面和“远端”(或“增强”)面。“近端”状态面投射显示在司机前方发动机罩的前部位置,它向司机有选择地显示状态信息,例如:当前车速、需遵守的诸如禁止超车区等距离限制和限速、或自适应巡航控制系统(ACC)的当前设置等信息。司机只需降低约6°视角,就可看到这些信息。状态信息的视场大小为5°×1°(相当于210mm×42mm),投影距离为2.4m。

图2:投影光路原理图。

其相当于“传统”平视显示器的虚拟图像,基于反射镜光学和图像生成单元(PGU)。PGU由薄膜晶体管(TFT)显示器构成,其内容使用LED背光。PGU采用紧凑设计被集成进AR-HUD模块的上部。镜头光学对显示内容进行放大以实现虚拟呈现,它是由曲面镜实现的。大陆集团在AR-HUD内采用精心打造的光学设计实现由不同投影距离生成的两个画面。在此,这两个光路在内部稍微重叠。近端面光路只使用大的AR-HUD镜(大的非球面镜)的上部边缘区,没有另外的“折叠镜”。AR-HUD系统的这一部分类似于大陆集团集成在现产汽车的第二代HUD所用的先进技术。

借助电影技术的车辆增强现实显示技术

而增强面自然在AR-HUD内扮演着主角。它将增强了的显示符号直接投射在驾驶员前方7.5米处的道路上,内容会基于当前的交通状况进行调适。该远端面显示的内容是由大陆集团首次在IAA 2013展出的一款新的图像生成单元生成的。图形元素是由数字微镜器件(DMD)以与数字电影放映机相同的方式生成的。PGU的核心是由几十万微镜矩阵构成的光学半导体结构,每一微镜都可单独由静电场偏置。

该微镜矩阵由三色LED(红、绿、蓝)按时间顺序快速、连续、交替点亮。通过带滤色功能(“分色镜”)的偏置镜,产生平行方向的三色光视觉瞄准(collimation)。根据颜色的不同,这些特殊的微镜或允许光线通过或反射光线。处理这三种颜色的所有微镜被当前点亮的颜色所同步偏置,所以它们通过镜头反射了入射光,并在光路后面的聚焦屏上将这种颜色呈现为独立象素。对所有三种颜色来说,这是同时发生的。人眼在聚焦屏幕上对这三种彩色画面进行“调和”,并得到全彩画面的主观视觉。

从聚焦屏的前面看下去,其后的光路相应于一款常规抬头显示器,其中:经由聚焦屏、使用第一个镜头(折叠镜)将图像反射到第二个更大的镜头(AR-HUD镜)的。再经由AR-HUD镜,图像被反射到前方屏幕。用于该增强功能的光学系统的射光面约为一张A4纸大小;也即,在增强级,视域相当于10°×4.8°,换算成可直接观看的增强视域约为:130cm(宽)×63cm(高)。司机只需稍微将其视线下调2.4°,就可看到该显示面信息。近端和远端这两种图像产生单元可根据环境光亮度产生不同亮度的显示,亮度可达超过10,000坎德拉/平米。因此,几乎在所有环境光条件下,都可容易地看清显示信息。

大陆在测试车辆上的AR-HUD所采用的、在不同投影距离生成两个画面的系统方法具有显著优势。在大多数交通条件下,可同时在远端和近端面呈现内容。这就允许将所有相关的驾驶和状态信息显示在司机可直接观看的视域。

AR-Creator的数据融合和图形生成

众多的模拟和大陆集团的真人测试(subject tests)表明:当对从车前约18到20米开始、并接续到大约100m的这段道路实现增强时,驾驶员感觉最爽,当然这还与路况相关。AR-Creator控制单元必须评估若干传感器数据流以将图形元素投放在聚焦屏的确切位置,再经由聚焦屏,这些图形被精确地反射进司机的AR-HUD视域。这需要大量运算。

AR-Creator将三个来源的数据进行融合。单通道摄像头提供道路布局的几何形状。还将“羊角曲线(Euler spirals)”或车辆前方车道曲率如何变化的数学描述考虑在内。基于雷达传感器数据和对相机数据的解释这两个因素综合判断车辆前方可检测目标的大小、位置和距离。最后,大陆集团的eHorizon提供地图框架,在该框架内读取感知的现场数据。演示车所用的这款eHorizon是静态的,仅使用导航数据资料。大陆集团已经着手生产后续的联网和高度动态的eHorizon产品,将支持拟用于在AR-HUD上显示的多种(即来自车到车、交通控制中心等的)数据源。整合了车辆动态信息、摄像头和GPS数据后,可在数字地图上显示车辆的位置。

AR-Creator还利用合并的数据来计算:从驾驶员的位置,观察前面道路的几何布局会是怎样一种情况。因为已知驾驶者的眼位置,所以这是可能的。在开始驾车前,驾驶员要在演示车辆设置“眼睛盒(eye box)”的正确位置。该过程可由批量生产(series production)的内部相机自动完成。该摄像头可检测驾驶员眼睛的位置,并可以跟踪眼睛盒的位置。术语“眼睛盒”表示一种矩形区域,其高度和宽度相当于理论上的“视窗”。当通过该视窗查看道路时,驾驶员只会看到完整的AR-HUD画面。车内乘客看不到HUD和AR-HUD显示的内容。

基于可调节眼镜盒的位置,AR-生成器“知道”驾驶员的眼睛所在,以及驾驶员在从哪个角度查看道路和周围环境。如果辅助系统报告一个相关观察,相应的虚拟信息就会出现在AR-HUD的正确点上。

少即是多

大陆集团为设计虚拟信息进行了大量研发工作。经过多次设计研究和真人测试,大陆集团研发AR-HUD时,遵循“少即是多”这一宗旨。开发人员希望仅将最少的必要信息呈现给驾驶员,以避免遮碍真实路况观察。

例如,作为导航辅助工具,可选择是否将角箭头“平放”在道路上。在转向时,角箭头可以直立起来并指向拟转的方向,它们看起来像个方向标志。这种设计使得能以窄曲线给出虚拟信息,尽管在这种情况下,由于缺乏透视视觉范围,真正的增强不可能。

对于压越车道的行为予以谨慎警告。若驾驶员很可能是无意压越车道,演示车辆的AR-HUD仅对车道边界进行高亮警示。

以后,若eHorizon事先收到事故信息,具有相应高注意值的危险符号会充分提前地出现在驾驶员的视野内。一旦安装了这种新的与驾驶员的交互形式,HMI就有很多选择主动向驾驶员提供具有场景内容的前瞻性信息。车辆和驾驶员就会开始“交谈”,即便这是场无言的交流。